Step 1 of 4

Un peu d'épistémologie

La connaissance scientifique est par nature dynamique et dubitative; elle n'est jamais une certitude: "Dans un sens, toute vérité n'est qu'une erreur qui corrige une autre erreur" (V. Frankl). Elle progresse par essais successifs et par corrections continues, à la manière des robots cybernétiques. L'activité humaine de connaître ne mène jamais à une image des phénomènes qui soit certaine et vraie, mais seulement à une interprétation conjecturale de phénomènes caractérisés par leurs régularités [14]. Karl Popper l'a superbement décrit: "La science ne repose pas sur une base rocheuse. La structure audacieuse de ses théories s'édifie en quelque sorte sur un marécage. Elle est comme une construction bâtie sur pilotis. Les pilotis sont enfoncés dans le marécage, mais pas jusqu'à la rencontre de quelque base naturelle ou "donnée" et, lorsque nous cessons d'essayer de les enfoncer davantage, ce n'est pas parce que nous avons atteint un terrain ferme. Nous nous arrêtons tout simplement parce que nous sommes convaincus qu'ils sont assez solides pour supporter l'édifice, du moins provisoirement" [10]. Toute théorie scientifique peut être mise en défaut par une nouvelle observation ou un nouveau paradigme; elle n'est jamais "ultime", mais toujours momentanée, provisoire et attaquable, "falsifiable" comme il est convenu de l'appeler [11]. Toute pensée scientifique est également tributaire d’un ensemble de concepts tacitement acceptés et partagés par la communauté intellectuelle, qui forment le paradigme momentanément en vigueur au sein de la société. Toute recherche et toute observation sont conçues et interprétées en fonction de ce paradigme, qui est le cadre mental dans lequel évolue la pensée de cette période. Etant structuré et cohérent, ce paradigme se modifie peu, mais il peut s’effondrer devant des découvertes qui contredisent ses fondements [7]. Il laisse alors la place à un nouveau paradigme, au cours d’une de ces révolutions scientifiques qui jalonnent l’histoire, comme celles déclenchées par Galilée, Copernic, Pasteur ou Einstein.

Ceci soulève une question fondamentale: dans quelles circonstances des conclusions peuvent-elles être considérées comme valides ? Pour ce faire, elles doivent remplir un certain nombre de conditions [4] :

Ceci soulève une question fondamentale: dans quelles circonstances des conclusions peuvent-elles être considérées comme valides ? Pour ce faire, elles doivent remplir un certain nombre de conditions [4] :

- Leur base est un collectif de données objectives analysable statistiquement;

- Ces données sont susceptibles d'être organisées en une théorie cohérente;

- Cette théorie prédit certaines observations que l'on peut effectivement faire;

- Ces observations sont reproductibles par d'autres équipes.

Dans le domaine de l'anesthésie, le premier point est rempli par les nombreuses études expérimentales et cliniques rétrospectives ou prospectives dont les résultats statistiques, particuliers à chacune d'entre elles, sont des acquis incontestables. Leur organisation en théories cohérentes est actuellement beaucoup plus touffue. Une explication théorique est une proposition qui reformule les observations en un système de concepts acceptable pour un groupe d'experts qui partagent les mêmes critères de validation [8]. Hormis la rigueur de l'observation et la cohérence logique des conclusions, ces critères sont souvent mal définis en médecine. La prédiction des observations - le troisième point - est naturellement limitée dans des systèmes aussi complexes qu'un organisme humain soumis au stress d'une opération. Quant au dernier point, la littérature médicale de ces vingt dernières années abonde en études cardiovasculaires dont les résultats n’ont jamais pu être reproduits.

Cela n’est guère surprenant, parce que l'équilibre hémodynamique est un système multifactoriel en réajustement constant. Nos mesures ne perçoivent que la résultante des interactions et rétro-actions complexes entre de très nombreux facteurs. Or, dans les systèmes complexes, la causalité n'est plus linéaire mais elle est multiple et interdépendante: modifier un élément du système peut ou non entraîner des conséquences selon l'état des autres éléments du système au sein duquel il interagit. L'erreur logique fondamentale consiste à confondre participation essentielle et responsabilité unique [8]. Pour que surviennent une panne ou un accident, il faut que plusieurs éléments soient atteints: chaque modification rétrécit la marge de sécurité de l'ensemble, mais n'est pas à elle seule la cause déclenchante. En fait, il n'est pas étonnant que l'on éprouve tant de difficultés à mettre en évidence des facteurs prédictifs indépendants, par exemple dans l'estimation du risque opératoire, car la méthode classique d'investigation ne permet d'étudier une relation qu'après l’avoir isolée de l’ensemble complexe du système global. Mais la sélection d’un axe d'analyse unique transforme l’objet observé en un mode de causalité dominante parce qu’on réduit au minimum les régulations multiples qui fonctionnent au sein dudit système [1]. La relation observée n’a de valeur prédictive que dans le contexte particulier de cette analyse-là; elle a toutes les chances de ne pas être reproductible dans un autre contexte [12].

Car la relation de causalité peut prendre schématiquement deux aspects bien différents. La causalité déterministe est caractérisée par une relation directe entre la cause et son effet ; dans ce système, la cause est l’élément nécessaire et suffisant pour que se produise l’effet. La répétition de la cause engendre à chaque fois la répétition de l’effet. C’est en isolant un phénomène simple et en observant son évolution que se sont construites les théories scientifiques en physique classique comme en biologie. Mais le phénomène n'est simple que pour notre esprit, et les lois que nous déduisons de nos observations ne sont que la traduction dans un langage d'une observation qui nous apparait comme telle parce que nous avons exclu tous les autres éléments de notre expérience. La question posée détermine la réponse obtenue. Nous ne pouvons pas savoir si notre déduction correspond à une réalité du monde ou si elle n'est qu'une interprétation statistiquement cohérente à l'intérieur d'un système mental préconçu. La causalité probabiliste, au contraire, n’entretient pas de relation directe et univoque entre une cause et un effet. La même cause peut produire un effet différent selon le contexte. Plusieurs mécanismes sont requis pour provoquer l’effet, mais ils sont eux-mêmes interdépendants. Ainsi le phénomène observé est d’origine multifactorielle et ne peut pas être isolé de son contexte. Il existe même une incertitude fondamentale sur la possibilité de déterminer les enchaînements qui conduisent à l’effet observé. On peut certes remonter les successions d’évènements qui ont conduit à un phénomène pour tenter de l’expliquer, mais cette filiation n’est pas la seule possible. Ce qui est juste dans un cas peut se révéler erroné dans un autre. Un succès isolé ne garantit nullement que la théorie soit adéquate. De ce fait, on ne peut pas prévoir comment se mettront en place les multiples éléments en jeu afin d’anticiper ce qui va se produire. L’Histoire en est la meilleure illustration : elle peut tout expliquer en remontant dans le passé, mais elle ne peut rien prévoir en extrapolant dans le futur. Elle fonctionne en marche arrière: elle définit des enchaînements de cause à effet parce qu'elle reconstruit les causes à partir des effets. Elle a toujours raison parce qu'elle connaît déjà le devenir des évènements lorsqu'elle recherche leurs origines. Comme n'importe quelle présentation de cas dans un colloque morbidité-mortalité, elle est constamment menacée par le piège du "Post hoc ergo propter hoc" (après cela, donc à cause de cela) qui attribue une relation de causalité à la simple succession temporelle de deux phénomènes. Le mental humain, curieux et inquiet dès l'origine, a besoin de trouver une cohérence dans le monde qui l'entoure pour pouvoir le gérer; il prend facilement une explication possible pour une preuve formelle.

L'instrument de mesure lui-même conditionne les résultats. Nous n'observons pas la nature elle-même, mais la nature soumise à nos méthodes d'investigation [5]. Or, c'est l'observateur qui définit les paramètres. En anesthésie, par exemple, le système de lecture "pression-débit" traditionnel (cathéter de Swan-Ganz) observe l'hémodynamique sous un angle qui lui est propre, mais qui ne permet pas de voir la totalité des phénomènes. Un autre système, tel celui des données "flux-volume" fourni par l'échocardiographie, opère des mesures sous un autre angle et peut, de la même situation, fournir des interprétations différentes. La sensibilité et la spécificité de chaque méthode varie selon les types de lésions et les classes de patients : L'ECG, qui analyse les modifications électriques liées aux variations du débit coronaire, a une sensibilité variable selon le type d'ischémie en cause. Il est vain de décider arbitrairement qu'un mode d'observation est l'étalon-or; il s'agit de les utiliser de concert pour qu’ils se complètent mutuellement, et de construire ainsi par bribes et par morceaux le modèle le plus adéquat possible de la réalité.

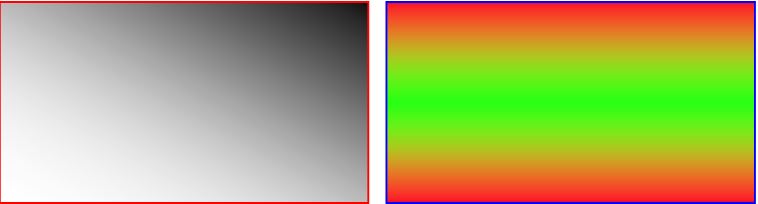

Cette dépendance vis-à-vis du système d'observation a des conséquences cliniques immédiates. Selon que l'on utilise le taux de CK-MB, les critères de l'OMS (angor, modifications ECG et élévation des CK-MB), la troponine I ou la troponine T, l'incidence de l'infarctus myocardique postopératoire varie entre 1.4%, 3%, 12% ou 17% respectivement [6,13]. Une élévation minime des troponines à haute sensibilité (TnT-hs 0.03-0.4 ng/mL) est présente chez 8-19% des patients à risque dans le postopératoire, bien que 58% d’entre eux ne remplissent pas les critères d’un infarctus et que 84% soient asymptomatiques. Ils souffrent de ce qu’il est convenu d’appeler un MINS (Myocardial Injury after Noncardiac Surgery) [2,9]. Ce phénomène est accompagné d'un triplement de la mortalité cardiovasculaire et d'une amélioration du pronostic lorsqu'un traitement classique de l'ischémie est mis en route [3]. Dans ce cas, le problème est d'une part de savoir si un système de mesure surestime l'incidence de l'affection. Augmenter la sensibilité sacrifie la spécificité: on risque de traiter des affections qui n'existent pas. De plus, nous avons tendance à confondre le marqueur d'un phénomène avec le phénomène lui-même. La troponine n'est pas l'infarctus, les CEA ne sont pas le cancer du côlon, et le chiffre du BIS™ n'est pas le sommeil du malade. La carte géographique n'est pas le territoire ! D'autre part, le problème est plus fondamental: nous fragmentons le réel en une multiplicité d'entités définies par notre langage, dont nous sommes tributaires pour nous y repérer, alors que la réalité est un fondu-enchaîné complexe auquel nous n'avons accès que par le biais des représentations que nous nous en faisons (Figure 1.5).

Figure 1.5 : Exemples de fondu-enchaîné. Dans la figure de gauche, il est évident que l’angle supérieur droit est noir et l’angle inférieur gauche blanc, mais la limite entre les deux couleurs est un dégradé progressif dans la densité des pixels noirs qui exclut de tracer une limite distincte entre le noir et le blanc. La diagonale du rectangle, qui est la médiane statistique du gris équilibré, peut être envisagée comme limite arbitraire parce que la figure est de géométrie simple. La figure de droite est déjà plus compliquée puisqu’on assiste à deux passages horizontaux entre le rouge et le vert sans qu’il soit possible d’attribuer une limite géométrique aux deux couleurs, bien qu’il soit évident que les bords sont rouges et le centre vert.

Dans la réalité, les formes, aussi bien que les processus ou les maladies, sont infiniment plus complexes que celles de la figure. Mais le problème est le même: définir une zone de couleur, comme définir un infarctus, consiste à tracer une limite à l'intérieur de laquelle existe l'entité en question et au-delà de laquelle elle n'existe pas. Cette frontière n'a pas d'existence réelle; elle marque une limite entre des entités que nous définissons pour nous les représenter avec discrimination et les manipuler avec précision. Mais ce qui erroné d’un point de vue ontologique reste utilisable d’un point de vue pragmatique. Néanmoins, la volonté de circonscrire et de définir les choses barre tout accès direct à la réalité et contraint définitivement à ne pouvoir connaître que notre représentation du monde, non le monde lui-même. Les MINS correspondent-ils à une réalité nosologique ? La réponse à cette question ne peut être qu'une tautologie puisque le langage qui définit le phénomène est le même que celui qui codifie notre représentation de l'ischémie myocardique. Nous sommes prisonniers de la convention qui veut que le réel soit sécable en petites entités autonomes que nous définissons, que nous nommons et que nous combinons ensemble pour construire un édifice physiopathologique cohérent pour notre raison. Ces entités entretiennent avec le réel une relation à distance analogue à celle qui sépare et relie tout à la fois le mot et l'objet qu'il décrit. Mais ceci n'est qu'une des lectures possibles du réel. Tout ce que nous pouvons en dire est qu'elle fonctionne plutôt bien dans notre conception du monde, qui n'est est qu'une parmi d'autres.

| Un peu d'épistémologie |

|

La science est un langage décrivant nos représentations du monde fondé sur la régularité des phénomènes auquel nous attribuons le statut de loi. Les "vérités" scientifiques ne sont jamais des certitudes acquises mais sont par nature susceptibles d'être remises en question par de nouvelles découvertes. La relation linéaire entre la cause et l'effet n'est vérifiable que dans des systèmes simples artificiellement isolés de leur contexte. Les systèmes complexes qu'analyse la médecine relèvent d'une causalité multifactorielle ou probabiliste. Leur investigation dépend fondamentalement de l'instrument de mesure utilisé. Pour pouvoir le gérer selon nos paradigmes, nous fragmentons le réel, par nature continu, en entités isolées et définies qui sont à la base de la physiopathologie et de la nosologie. Ces entités correspondent au fonctionnement de notre raison; elles ont par rapport au réel la même distance que celle qui sépare l'objet du mot qui le décrit. |

© CHASSOT PG Avril 2007 Mise à jour Janvier 2012, Juillet 2017

Références

- AMZALLAG GN. La raison malmenée. Paris, CNRS Edition, 2002

- BOTTO F, ALONSO-COELLO P, CHAN MT, et al. Myocardial injury after noncardiac surgery: a large international prospective cohort study establishing diagnostic criteria, characteristics, predictors, and 30-day outcomes. Anesthesiology 2014; 120:564-78

- FOUCRIER A, RODSETH R, AISSAOUI M, et al. The long-term impact of early cardiovascular therapy intensification for postoperative troponin elevation after major vascular surgery. Anesth Analg 2014; 119:1053-63

- HAYWARD JH. Scientific method and validation. In: HAYWARD JW, VARELA FJ. Gentle Bridges. Shambala Ed., Boston, 1992

- HEISENBERG W. Physics and philosophy, the revolution in modern sciences. Harper, New-York, 1958

- KEMP M, DONOVAN J, HIGHAM H, HOOPER J. Biochemical markers of myocardial injury. Br J Anaesth 2004; 93:63-73

- KUHN TS. The structure of scientific revolutions. Chicago: University of Chicago Press, 1962

- MATURANA HR, VARELA FJ. The Tree of knowledge. Shambala, Boston, 1992

- OBERWEIS BS, SMILOWITZ NR, NUKALA S, et al. Relation of perioperative elevation of troponin to long-term mortality after orthopedic surgery. Am J Cardiol 2015; 115:1643-8

- POPPER K. La logique de la découverte scientifique. Payot, Paris, 1973

- POPPER K. L'Univers irrésolu, plaidoyer pour l'indéterminisme. Hermann, Paris, 1984

- PRASAD V, VANDROSS A, TOOMEY C, et al. A decade of reversal: an analysis of 146 contradicted medical practices. Mayo Clin Proc 2013; 88:790-8

- PRIEBE HJ. Triggers of perioperative myocardial ischemia and infarction. Brit J Anaesthesiol 2004; 93:9-20

- WATZLAWICK P. L'invention de la réalité. Contribution au constructivisme. Seuil, Paris 1988